卷积神经网络#

直观理解#

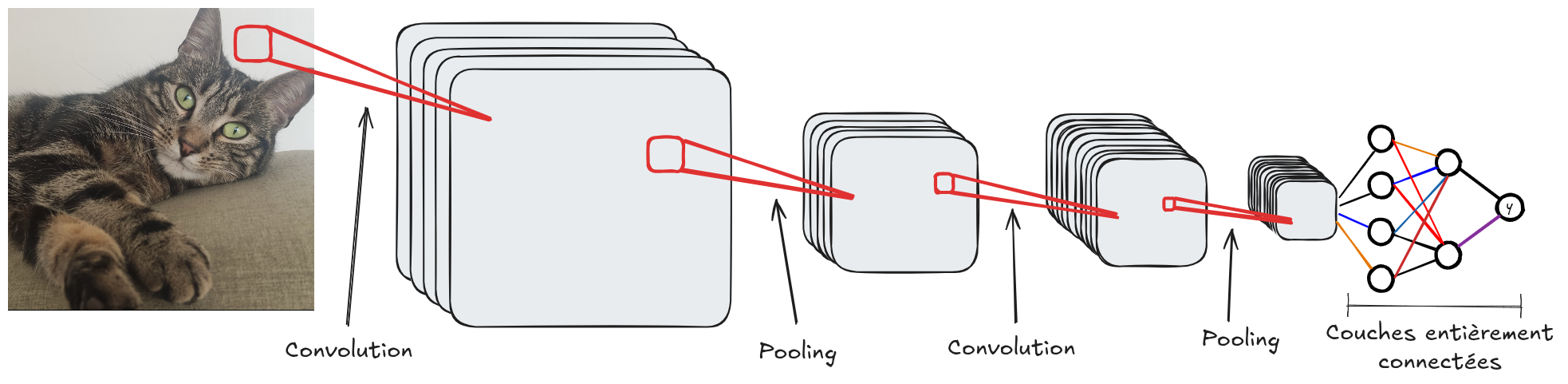

与全连接网络类似,卷积神经网络也由多个层组成。其核心思想是:

增加深度方向的滤波器(通道)数量,同时减少特征图的空间分辨率。

这种设计提升了网络的抽象能力:浅层主要检测边缘等局部特征,而深层则捕获更复杂的上下文信息。

在分类任务(如 MNIST 手写数字识别)中,网络末端通常采用全连接层,将卷积输出的特征映射到类别数量上,以实现最终分类。

典型的卷积神经网络由以下三类层组成:

卷积层:调整滤波器数量,引入可训练参数;

激活层(如 ReLU、Sigmoid、Tanh 等):为网络引入非线性特性;

池化层:降低特征图的空间分辨率,减少参数量。

下图展示了经典卷积神经网络的架构示意:

感受野(Receptive Field)#

如前所述,单层卷积仅实现像素的局部交互。例如,采用 \(3 \times 3\) 的滤波器时,每个像素仅受其邻域像素影响。这种局部性限制了网络检测全局图像特征(如覆盖整个图像的模式)的能力。

然而,堆叠多层卷积可逐步扩大单个像素的影响范围(即感受野)。下图直观展示了这一原理:

图片来源:博文链接

感受野可通过以下公式形式化计算:

其中:

\(R_{Eff}\):输出层的感受野大小;

\(R_{Init}\):初始感受野(通常为 1);

\(k\):卷积核尺寸;

\(S\):步长(stride)。

在设计卷积网络时,必须验证感受野是否足够覆盖关键像素交互。原则上:

输入图像尺寸越大,所需的感受野范围应越广,以确保网络能捕获全局特征。

注: 之前介绍的模型优化工具(如批归一化 BatchNorm 和 Dropout)同样适用于卷积神经网络,可进一步提升其性能。

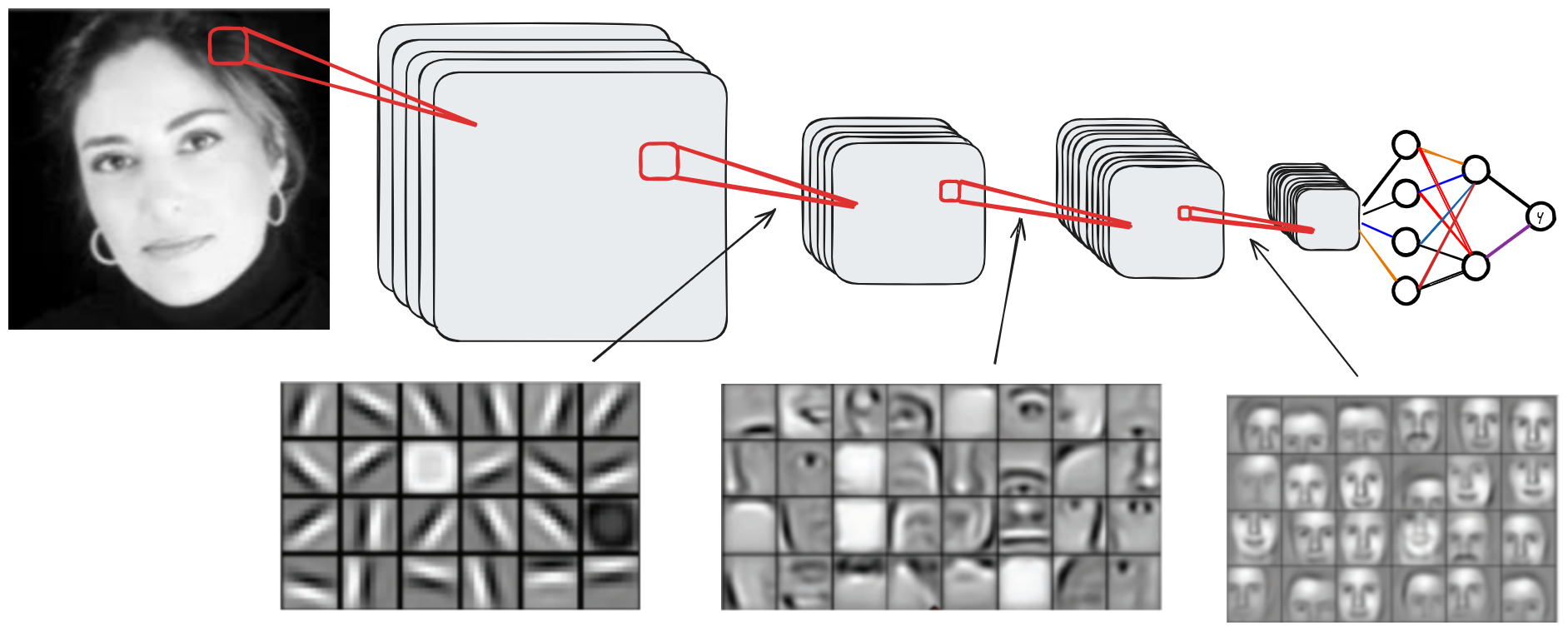

可视化:网络学习到的特征#

为理解卷积网络的工作机制及各层功能,可视化不同深度的特征图(FeatureMaps)激活是行之有效的方法。下图展示了随网络深度变化的特征图:

由图可知:

浅层:主要捕获局部信息(如边缘、基础形状);

中间层:提取覆盖图像较大区域的复合特征;

深层:整合上下文语义信息,实现高阶抽象(如物体部件或场景布局)。